Un papier d’Alexia Jolicoeur-Martineau qui fait de la recherche sur l’IA au Canada pour Samsung m’a interpellé : https://arxiv.org/pdf/2510.04871 Il a aussi déclenché pas mal d’articles.

L’étude, qui date d’octobre, présente une idée qui bouscule les approches habituelles de l’intelligence artificielle : on peut obtenir des capacités de raisonnement très élevées avec de très petits modèles, bien plus simples que les grands modèles de langage actuels (LLM) et même Small Language Models (SLM).

![]() L’auteure (avec un E) montre qu’il est possible d’entraîner un modèle minuscule (à peine quelques millions de paramètres), là où les IA modernes en utilisent plusieurs milliards tout en atteignant ou dépassant leurs performances sur certaines tâches logiques et de résolution de problèmes.

L’auteure (avec un E) montre qu’il est possible d’entraîner un modèle minuscule (à peine quelques millions de paramètres), là où les IA modernes en utilisent plusieurs milliards tout en atteignant ou dépassant leurs performances sur certaines tâches logiques et de résolution de problèmes.

L’astuce repose sur un principe simple. Au lieu de produire la réponse en une seule fois, le modèle raisonne par petites étapes, en améliorant progressivement sa solution. Via ce raisonnement récursif le modèle relit sa propre sortie, la corrige, l’améliore et recommence plusieurs fois.

On pourrait comparer cela à une personne qui résout un puzzle et qui pose des pièces puis vérifie et revient en arrière pour ajuster. (On essaye pas de deviner la solution tout de suite)

Ce modèle, appelé TRM (Tiny Recursive Model) est très léger et donc peu coûteux à entraîner,

Il offre une bonne capacité de généralisation et il réussit à résoudre des puzzles plus difficiles que ceux sur lesquels il a été entraîné.

L’étude montre qu’il fonctionne particulièrement bien sur :

- des Sudokus complexes,

- des labyrinthes à résoudre,

- des tâches de logique du benchmark ARC-AGI, considéré comme un test exigeant d’intelligence artificielle générale.

![]() Le raisonnement n’a pas forcément besoin d’un modèle gigantesque. La structure du modèle et la manière dont il réfléchit étape par étape comptent parfois plus que sa taille.

Le raisonnement n’a pas forcément besoin d’un modèle gigantesque. La structure du modèle et la manière dont il réfléchit étape par étape comptent parfois plus que sa taille.![]() L’étude porte essentiellement sur des tâches logiques très structurées.

L’étude porte essentiellement sur des tâches logiques très structurées.

L’avenir de l’IA n’est pas seulement dans le “toujours plus grand”, mais aussi dans des modèles intelligents, compacts et capables de raisonner de manière itérative.

Côté solutions de cybersécurité je ne crois pas qu’il y ait déjà des implémentations prévues mais on peut très bien imaginer l’exécution de type Edge Computing sur des sondes diverses et variées.

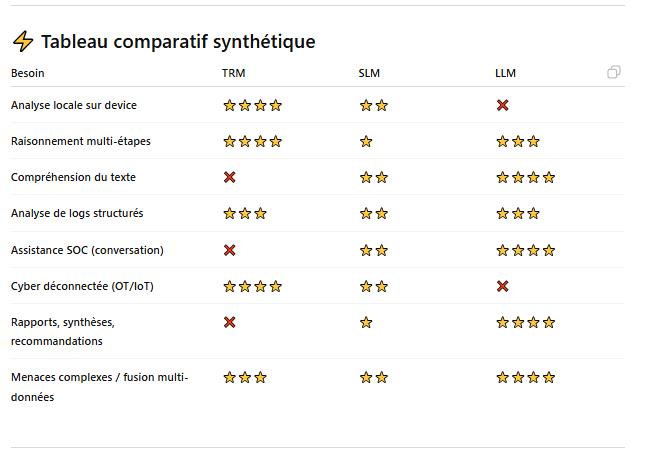

J’ai demandé à chatgpt de me générer un tableau sur les possibilités (je crois qu’on est pas loin du compte) :

Quelques liens :

Le benchmark mentionné plus haut ARC-AGI (Abstraction & Reasoning Challenge) : https://arcprize.org

Introduction aux modèles implicites / récursifs : https://deepai.org/publication/deep-equilibrium-models

Laisser un commentaire